- Logistic Regression(로지스틱 회귀)

ŷ (P(y=1|X): 입력 값인 X에 대해서, y(주어진 입력 특성 X에 해당되는 실제 값)가 1일 때의 예측값

예측값 ŷ은 X일 때 y가 1인 확률(0 ≤ ŷ < 1 사이의 값)

ŷ = wX + b (w, b = 파라미터, w = 입력 값, b = 잔차)에서 0과 1 사이의 확률 범위를 벗어날 수 있기에, 이때 시그모이드 함수(sigmoid function) 등을 활용해 0과 1 사이의 값으로 변환

- Logistic Regression cost function(로지스틱 회귀 비용 함수)

1) Loss(error) function(손실함수):

하나의 입력에 대해 실제값(y)와 예측값(ŷ)의 차이인 오차를 계산하는 함수

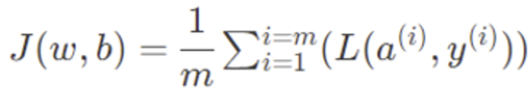

2) Cost function(비용함수):

모든 입력에 대한 오차를 계산하는 함수

모든 입력에대한 손실함수의 평균값으로 계산

회귀 모형을 사용하는 목적은 실제값(y)과 근접한 예측값(ŷ)을 찾기를 위함

비용 함수의 값이 작아지도록 하는 w와 b를 찾는 것이 이를 위한 방법

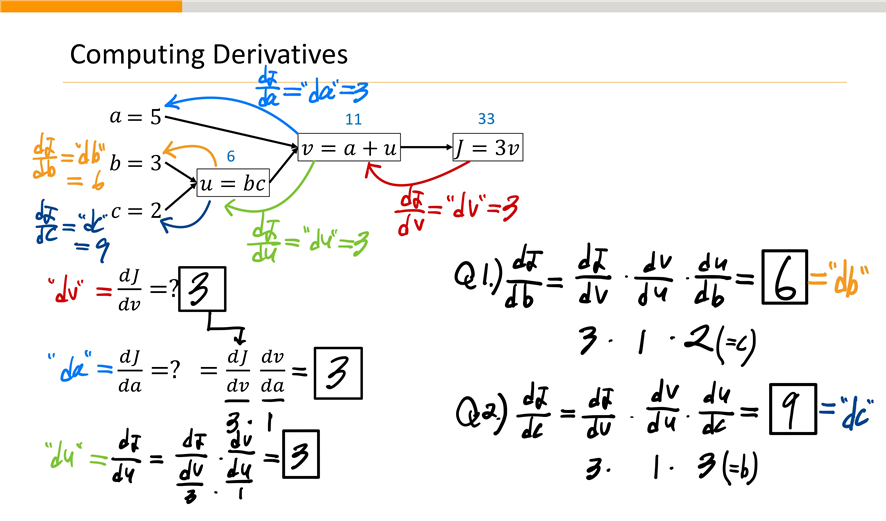

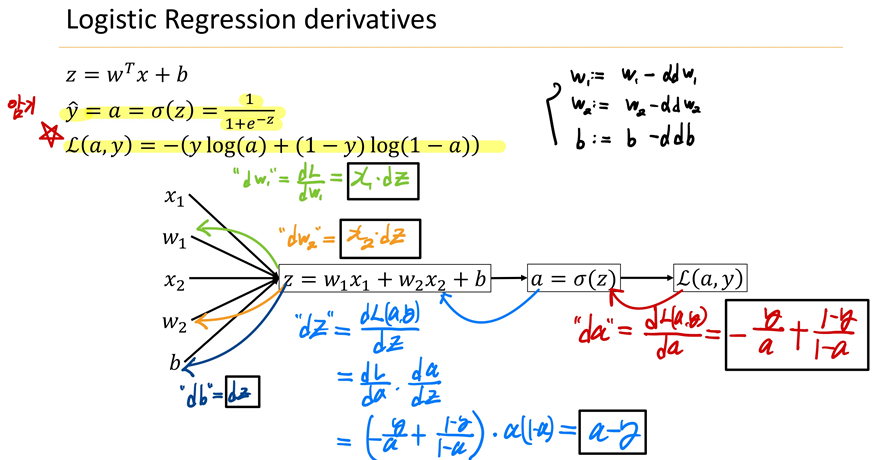

-Logistic Regression derivatives

-로지스틱 회귀에서 비용함수

- Vectorization(벡터화): 명백한 for loop를 제거하는것

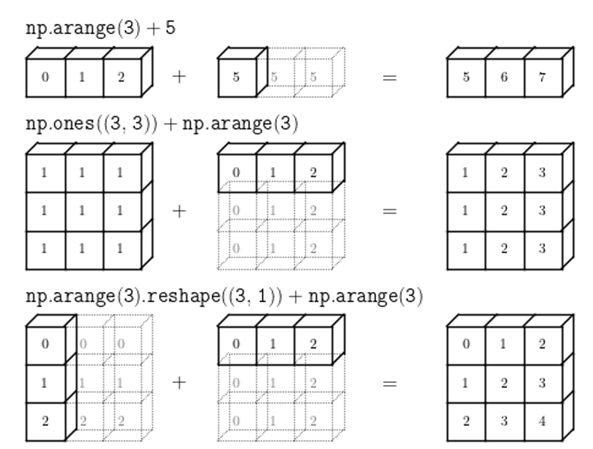

- Broadcasting(브로드캐스팅): 특정 조건을 만족하면 모양이 다른 배열끼리의 연산이 가능하게 해줌, 모양이 부족한 부분은 확장하여 연산을 수행

1) 차원의 크기가 1일때 가능

- 두 배열 간의 연산에서 최소한 하나의 배열의 차원이 1이라면(0번 축이든 1번 축이든; 1행이든 1열이든) 가능

2)차원의 짝이 맞을 때 가능합니다.

- 차원에 대해 축의 길이가 동일하면 브로드캐스팅이 가능하다.

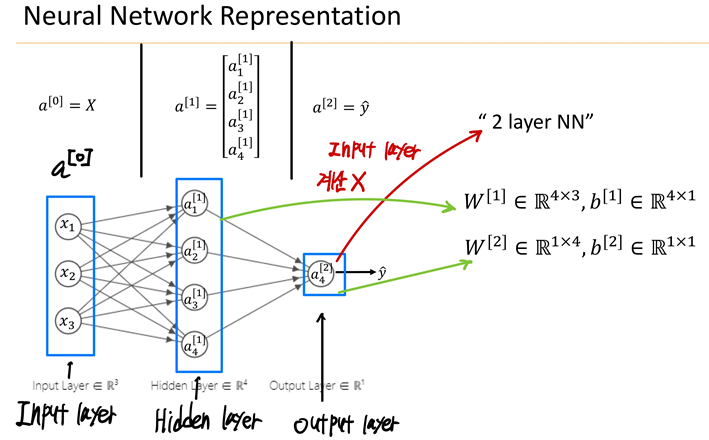

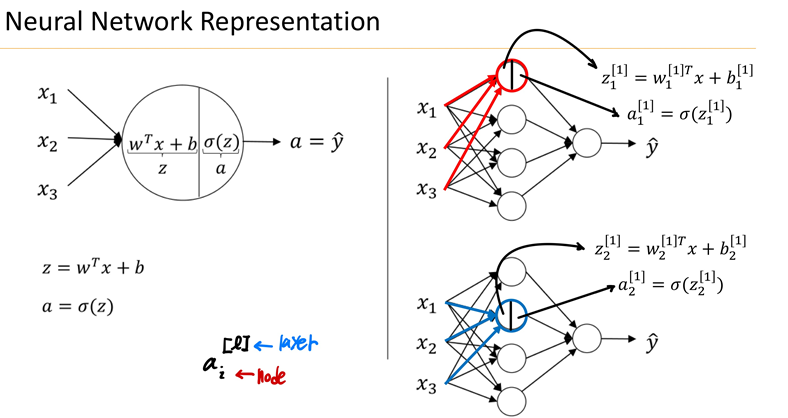

- Neural Network

Hidden layer: Input layer과 Output layer 사이에 있는 모든 층

신경망의 개수를 셀 때 입력층은 세지 않는다.

'3-1 > Deep Learning' 카테고리의 다른 글

| 6주차-Hyperparameters and Batch Norm (1) | 2024.05.11 |

|---|---|

| 5주차-Optimization Algorithms (1) | 2024.05.11 |

| 4주차-Practical Aspects of Deep Learning (0) | 2024.05.11 |

| 3주차-Deep Neural Networks (1) | 2024.05.11 |

| 1주차-Introduction to Deep Learning (1) | 2024.05.11 |