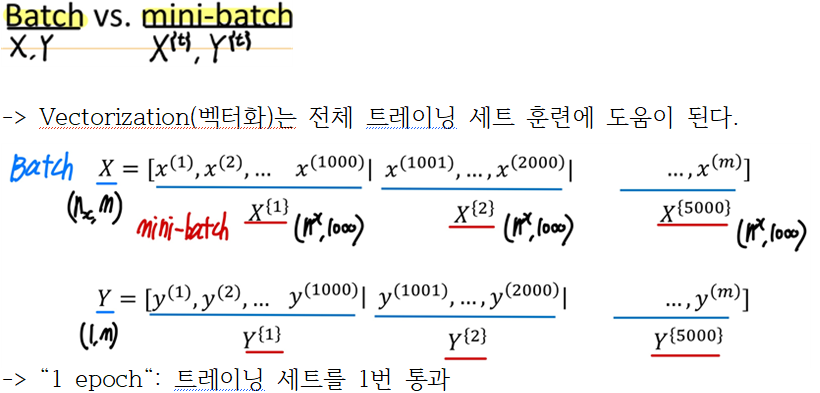

- Batch vs mini-batch gradient descent

- Batch

- Mini-batch

- mini-batch size:

1. small training set(m<2000): Batch G.D

2. Typical mini-batch size: 64, 128, 256, 512, 1024

3. mini-batch가 cpu, gpu 메모리에 들어가도록 하는 것이 중요

- Exponentially weighted averages (지수 가동 이동 평균법)

베타 높이면 (초록색 그래프) 선이 약간 오른쪽으로 이동

베타 줄이면 (노란색 그래프) 선 내에서 더 많은 진동이 발생

- Bias correction

Gradient descent

- Momentum

- RMSprop

- Adom optimization algorithm

Momentum과 RMSprop를 더해서 만든다.

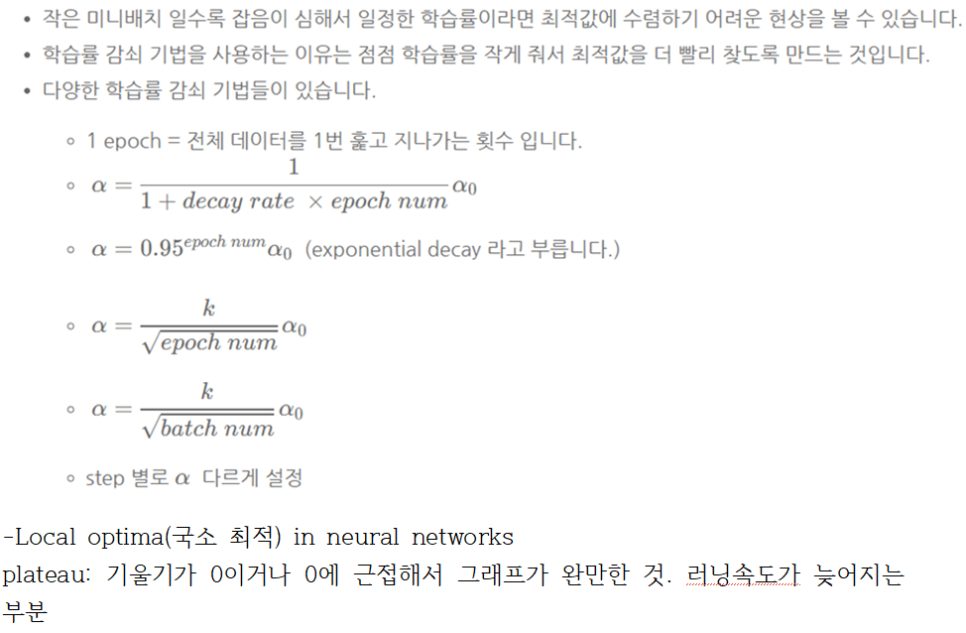

- Learing reate decay

'3-1 > Deep Learning' 카테고리의 다른 글

| 7주차-Convolutional Neural Networks (1) | 2024.05.11 |

|---|---|

| 6주차-Hyperparameters and Batch Norm (1) | 2024.05.11 |

| 4주차-Practical Aspects of Deep Learning (0) | 2024.05.11 |

| 3주차-Deep Neural Networks (1) | 2024.05.11 |

| 2주차-Shallow Neural Networks (2) | 2024.05.11 |