- Multi-class Classification

- binary classification에 관해서 다뤘었다 => Logistic Regression

- Multi-class Classification으로 확장을 해보자

- Decision Boundary of Multi-class Classification

- Softmax Regression(Classification)

<Softmax>

Logistic Regression의 일반화된 형태로 설명된다.- Softmax는 각 클래스의 확률을 계산하며, 계산된 확률의 총합은 항상 1이 된다.

- Softmax는 (one-shot) argmax의 smooth approximation으로 사용된다.

EX) Hard Max VS Soft Max

- Logistic VS Softmax

- Activation

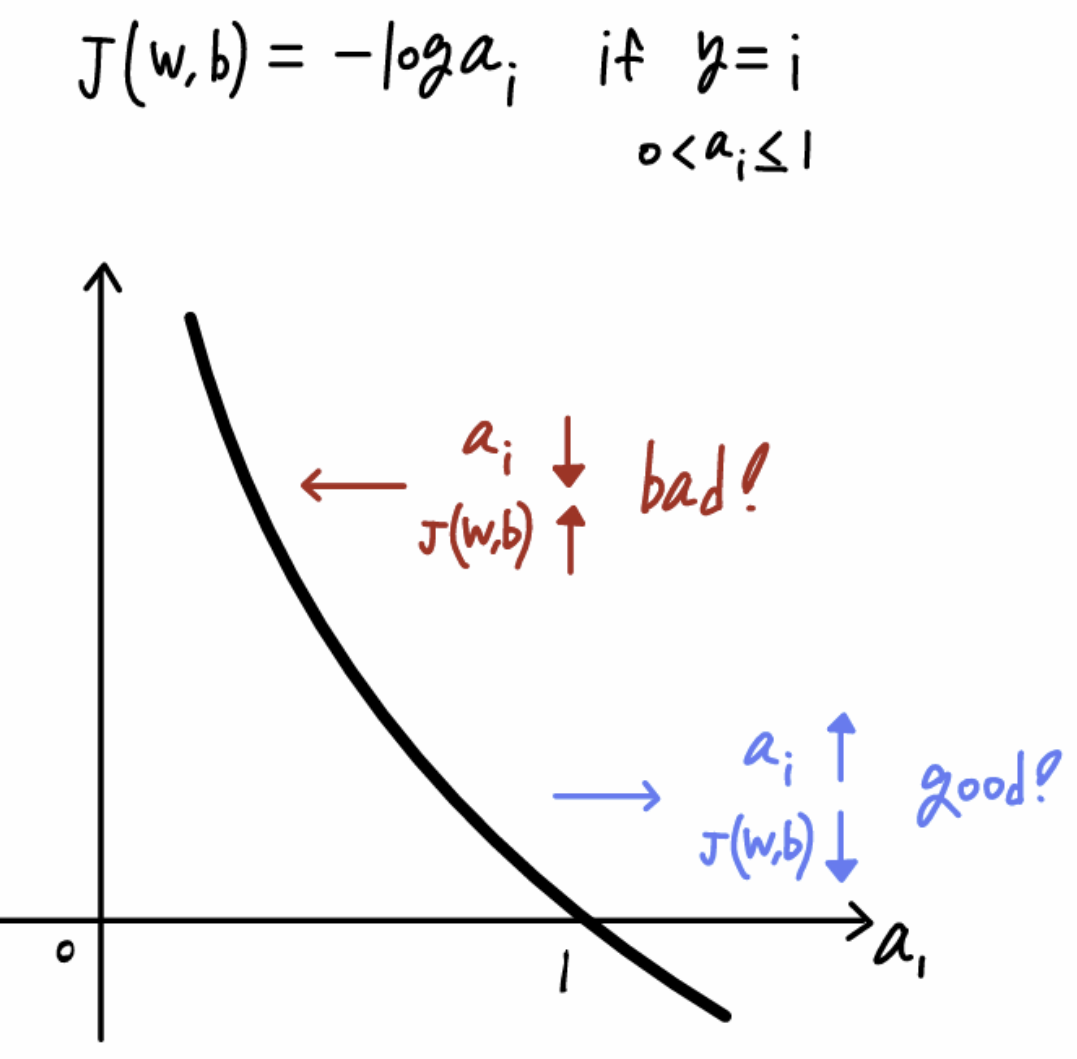

- Loss Function

=> Logistic Regression은 binary Classification에 적합

=> Softmax는 Multi-class Classification에 적합

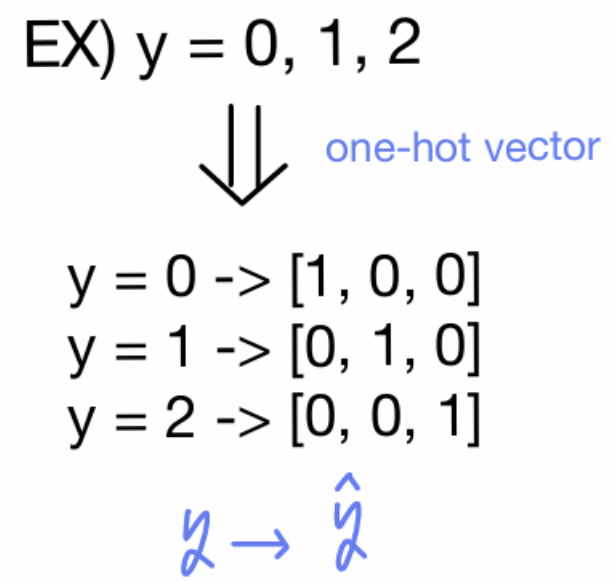

- One-hot Vector

- Class Label을 binary vector로 변환

EX)

#implimentation

ohv = np.zeros(c) # c는 클래스 개수

if index == y:

ohv[index] = 1.0

- Cross-entropy Loss

- Cross-entropy Loss with One-hot Vector

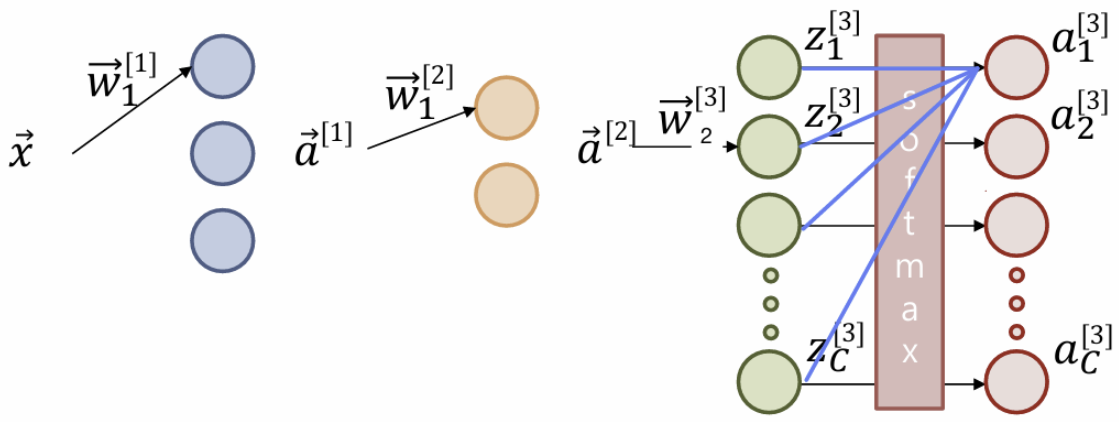

- Multi-activation

- Multi-activation Softmax layer

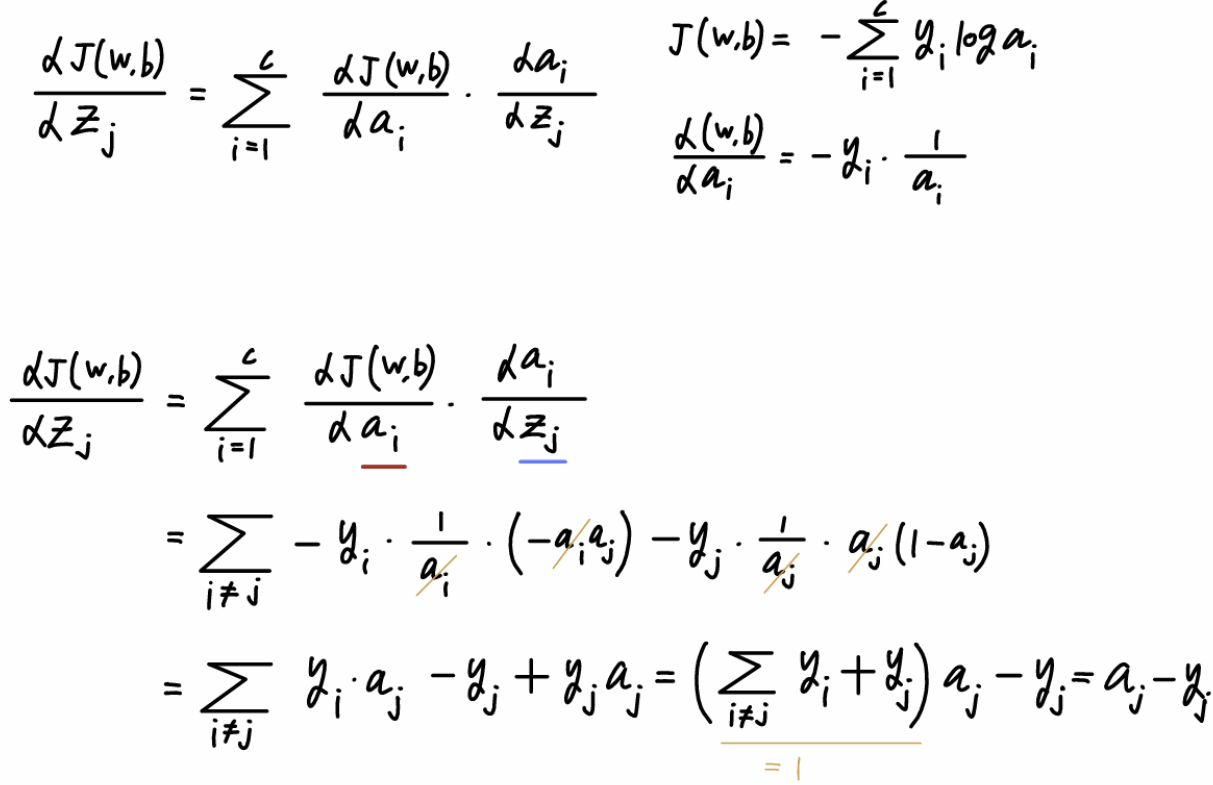

- Derivation of Softmax(Softmax의 미분)

- Derivation of CE Loss(Cross-Entropy의 미분)

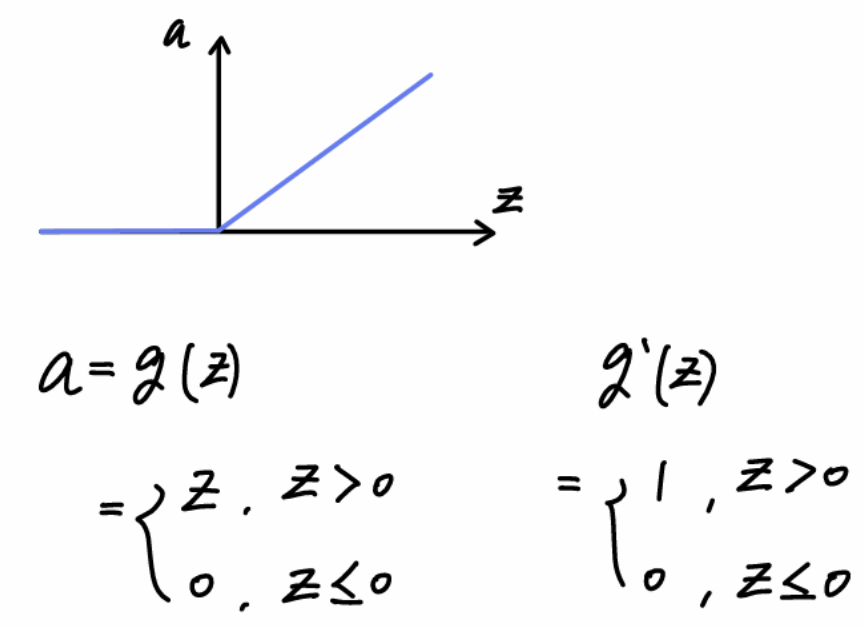

- Derivative of ReLU(ReLU의 미분)

- Loss Curve

- Loss surface와는 다른 것.<Loss Curve>

학습 과정 중 Loss Function 값 J(w)의 변화를 나타낸 그래프

- x축: training iteration or epoch

- y축: Loss function 값 J(w)

Loss Curve VS Loss Surface

- Loss Curve: 학습 반복에 따른 손실 변화(1D 그래프)

- Loss Surface: 매개변수 w공간에서의 손실 값 분포를 나타냄(2D or 3D 그래프)

'3-2 > 기계학습' 카테고리의 다른 글

| 12주차-Learning Strategies (0) | 2024.12.07 |

|---|---|

| 11주차-Loss Function Design (0) | 2024.12.07 |

| 9주차-Activations, Implementation Details of Neural Network (1) | 2024.11.27 |

| 8주차-Neural Network (0) | 2024.11.27 |

| 7주차-Regularization (2) | 2024.10.27 |